En un contexto en el que la inteligencia artificial está transformándose en un eje fundamental del desarrollo empresarial, las organizaciones están adoptando un enfoque novedoso al segmentar sus operaciones de IA en equipos especializados. El objetivo es claro: optimizar tanto el desarrollo como la implementación efectiva de modelos. Esta estrategia implica la formación de dos equipos clave: el equipo de investigación de IA, responsable del desarrollo y mejora de los modelos a través de técnicas avanzadas de entrenamiento, y el equipo de hospedaje, cuyo trabajo se centra en la implementación de estos modelos en diversos entornos como desarrollo, validación y producción.

En este escenario surge una herramienta tecnológica que facilita y dinamiza el proceso: Amazon Bedrock Custom Model Import. Esta solución está diseñada para ayudar al equipo de hospedaje a importar y manejar modelos personalizados apoyándose en arquitecturas reconocidas como Meta Llama 2 y Mistral. Utilizando un sistema de precios On-Demand, la herramienta permite la importación de modelos con pesos en el formato de Hugging Face safetensors desde Amazon SageMaker o Amazon S3. Este avance no solo facilita la interacción con los modelos de base existentes en Amazon Bedrock, sino que también refuerza la colaboración entre diversos equipos.

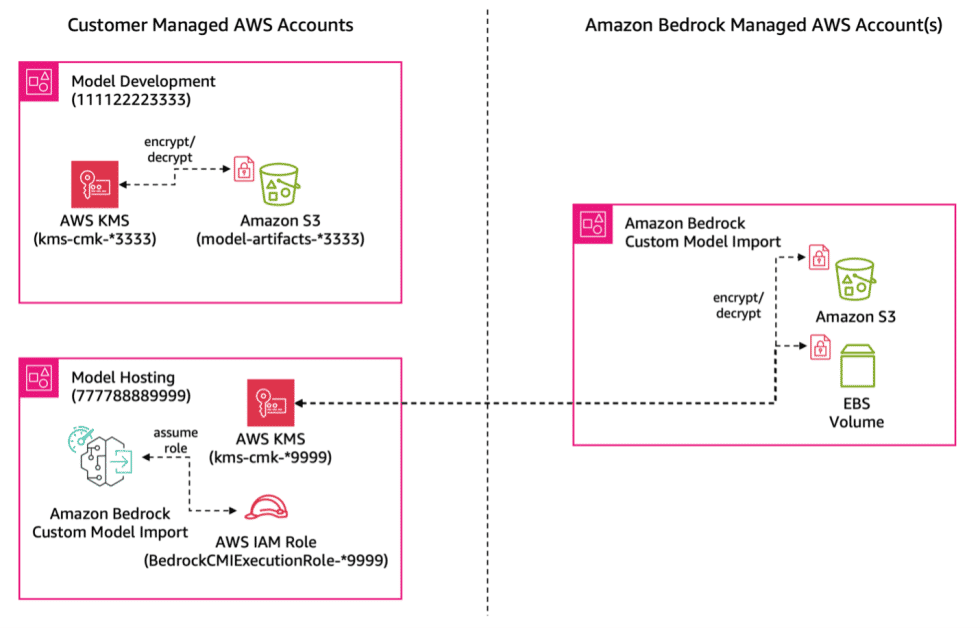

No obstante, uno de los retos más significativos en este proceso es el acceso a los artefactos de modelo, especialmente cuando estos se encuentran en cuentas de AWS separadas. Los resultados de los entrenamientos, incluidos los pesos del modelo, suelen almacenarse en S3 dentro de la cuenta del equipo de investigación. Por tanto, para el despliegue adecuado, el equipo de hospedaje necesita acceso a estos artefactos, un desafío que Amazon Bedrock Custom Model Import resuelve mediante el soporte de acceso entre cuentas.

Esta funcionalidad permite configurar accesos directos entre los buckets de S3 y las cuentas de hospedaje, optimizando el flujo de trabajo y asegurando la seguridad. Empresas como Salesforce ya están aprovechando esta funcionalidad, donde el equipo de plataforma de IA ha notado cómo esta integración ha facilitado la configuración, reduciendo la carga operativa y manteniendo los modelos seguros en su ubicación original.

Para garantizar una implementación efectiva y segura, se sugieren varios pasos. Estos incluyen la obtención de permisos entre roles de IAM y la configuración de políticas de recursos en los buckets de S3 y las claves de AWS KMS, asegurando así una protección robusta de los datos. Estas configuraciones no solo permiten al equipo de hospedaje acceder a los modelos importantes, sino que también aseguran que cada equipo conserve su autonomía y controles de seguridad.

Con el incremento del uso de innovaciones como Amazon Bedrock, este enfoque dual de especializar equipos y optimizar accesos se perfila como un estándar en organizaciones que buscan maximizar el potencial de la inteligencia artificial, asegurando al mismo tiempo altos niveles de seguridad y eficiencia operativa.